MPIの効率化に関する研究

JAXAスーパーコンピュータシステム利用成果報告(2024年2月~2025年1月)

報告書番号: R24JFHC0313

利用分野: 事業共通

- 責任者: 藤田直行, セキュリティ・情報化推進部スーパーコンピュータ活用課

- 問い合せ先: 鎌田 めぐみ, 小島 良実(kamata.megumi@jaxa.jp,kojima.yoimi@jaxa.jp)

- メンバ: 鎌田 めぐみ, 小島 良実

事業概要

計算流体力学(CFD)は, 航空宇宙工学において重要な技術であり, 高性能コンピュータの主要な応用分野です. ほとんどのCFDソフトウェアは, 並列化のためにMPIを使用しています. 大規模スーパーコンピュータでは, CFDに割り当てられた計算ノードがインターコネクトを介して散在しており, 遠くのノード間の通信がCFDソフトウェアの並列効率に影響を与えます. FugakuやJSS3(JAXAスーパーコンピュータシステム第3世代)などの近代的なスーパーコンピュータシステムは, 高効率で高スループットな通信を計算ノード間で提供するために, 高度なインターコネクト(Tofuインターコネクト)を採用しています. しかし, ネットワークトポロジーの高い複雑性により, CFDアプリケーションのデータ構造とは関係のない自動的なランク割り当てに依存するだけでは, 最適なMPI通信を実現することが難しいのです. 本研究では, 複雑なノード接続トポロジーを持つスーパーコンピュータシステム(Tofuインターコネクトなど)におけるCFDアプリケーションの最適なMPI通信を実現することを目的としています. 具体的には, JAXAが開発したCFDソルバーにMPIランクの再配置機能を実装し, その効果を評価します.

参照URL

なし

JAXAスーパーコンピュータを使用する理由と利点

本研究はスーパーコンピュータにおけるCFDアプリケーションの性能向上を目的とした研究であり, 実際のスーパーコンピュータ上でプログラムを実行することにより, その性能を検証する必要があるため, スーパーコンピュータを利用した.

今年度の成果

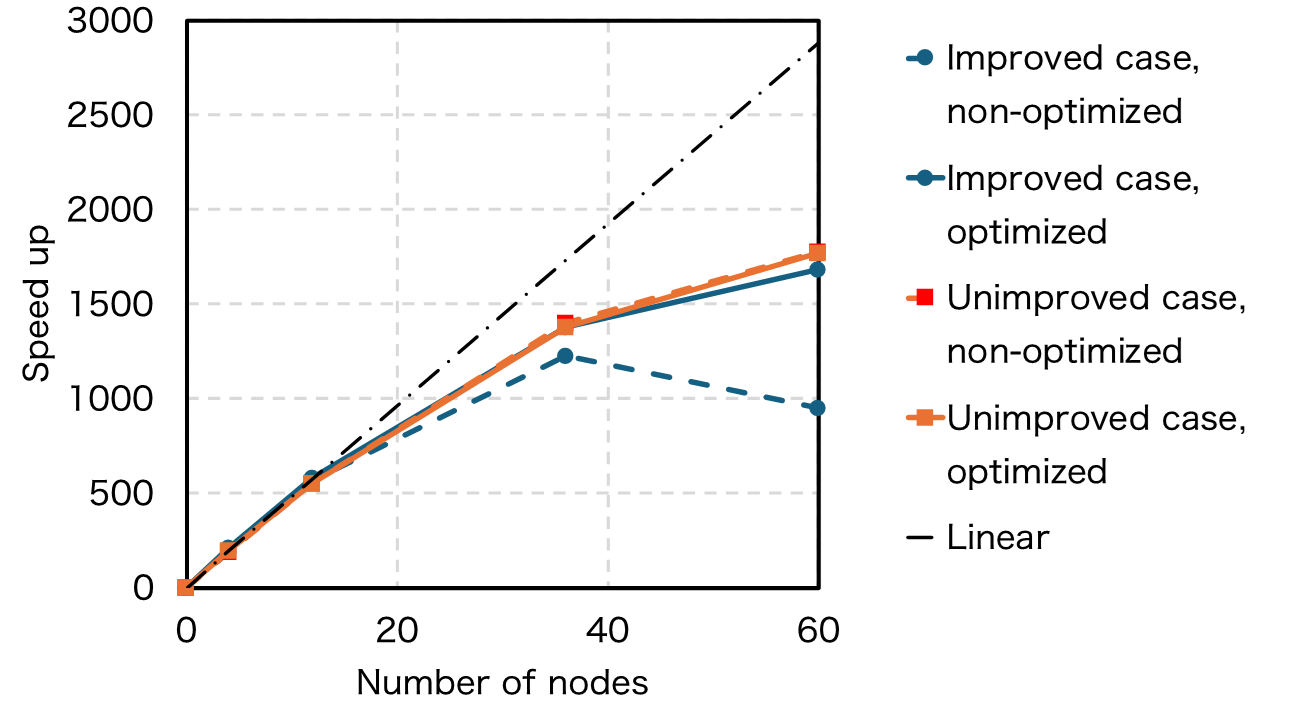

CFDアプリケーションのためにMPIランク最適化手法を実装し, 複雑なノード接続トポロジーを持つスーパーコンピュータでその効果を評価しました. 結果は, 特定の状況において最適化が強スケーリングを改善できることを示しています.

図1: 図は, MPIランク最適化を適用した場合の強スケーリングの大幅な改善を示す改善されたケース(青い曲線)を示しています. 一方, 改善されていないケースでは, 最適化されてもされなくても強スケーリングは改善されていません.

成果の公表

-その他

SC24のJAXAブースにてポスター発表

JSS利用状況

計算情報

- プロセス並列手法: MPI

- スレッド並列手法: 非該当

- プロセス並列数: 48 - 2880

- 1ケースあたりの経過時間: 30 分

JSS3利用量

総資源に占める利用割合※1(%): 0.11

内訳

JSS3のシステム構成や主要な仕様は、JSS3のシステム構成をご覧下さい。

| 計算システム名 | CPU利用量(コア・時) | 資源の利用割合※2(%) |

|---|---|---|

| TOKI-SORA | 3028682.76 | 0.14 |

| TOKI-ST | 3.99 | 0.00 |

| TOKI-GP | 0.00 | 0.00 |

| TOKI-XM | 0.00 | 0.00 |

| TOKI-LM | 0.00 | 0.00 |

| TOKI-TST | 0.00 | 0.00 |

| TOKI-TGP | 0.00 | 0.00 |

| TOKI-TLM | 0.00 | 0.00 |

| ファイルシステム名 | ストレージ割当量(GiB) | 資源の利用割合※2(%) |

|---|---|---|

| /home | 84.58 | 0.06 |

| /data及び/data2 | 8604.29 | 0.04 |

| /ssd | 726.55 | 0.04 |

| アーカイバシステム名 | 利用量(TiB) | 資源の利用割合※2(%) | J-SPACE | 17.59 | 0.06 |

|---|

※1 総資源に占める利用割合:3つの資源(計算, ファイルシステム, アーカイバ)の利用割合の加重平均.

※2 資源の利用割合:対象資源一年間の総利用量に対する利用割合.

ISV利用量

| 利用量(時) | 資源の利用割合※2(%) | |

|---|---|---|

| ISVソフトウェア(合計) | 0.00 | 0.00 |

※2 資源の利用割合:対象資源一年間の総利用量に対する利用割合.

JAXAスーパーコンピュータシステム利用成果報告(2024年2月~2025年1月)