宇宙システム解析検証(プロジェクト上流における複合モデルベースデザイン技術の構築)

JAXAスーパーコンピュータシステム利用成果報告(2023年2月~2024年1月)

報告書番号: R23JDG20177

利用分野: 研究開発

- 責任者: 清水太郎, 研究開発部門第三研究ユニット

- 問い合せ先: 水野 光, JAXA 研究開発部門 第三研究ユニット(mizuno.hikaru@jaxa.jp)

- メンバ: 河津 要, 倉田 博文, 水野 光

事業概要

近年, 宇宙機業界でもMBDアプローチやによる開発の効率化, デジタル化による開発手法刷新についての研究が盛んに行われている. 第3研究ユニットでは開発早期の宇宙機システム設計開発の効率化を目的として, モデルベース開発技術の取り込み・適用の研究を進め, 宇宙機設計に必要なシステムシミュレーション技術の開発を実施している.

本事業では, 衛星概念検討フェーズで実施されるMATLABやC/Pythonベースの各種シミュレーションの計算, 特にパラメータスタディやモンテカルロシミュレーションのような大量の計算をJSS3上で効率的に実行する手法研究開発を実施する.

参照URL

https://stage.tksc.jaxa.jp/jedi/sysd/index.html 参照.

JAXAスーパーコンピュータを使用する理由と利点

・JAXA職員であれば煩雑な手続き無しでクイックに利用可能であること

・JAXA内のシステムであるため, 同じJAXAイントラネット内で接続可能であり情報流出のリスクが少ないこと

・開発中の宇宙機の設計情報のような機微情報をJAXA内で閉じて取り扱えること

・システム使用方法について手厚いサポートがクイックに受けられること

・Linuxコンテナ技術に対応していること

今年度の成果

成果1.

22年度に開発したHTV-X自動ドッキング機構開発向けの制御パラメータのパラメータスタディを効率的に実行する仕組みをHTV-Xプロジェクトメンバーに展開し, モンテカルロシミュレーション等のシミュレーションの多数実行を効率化した.

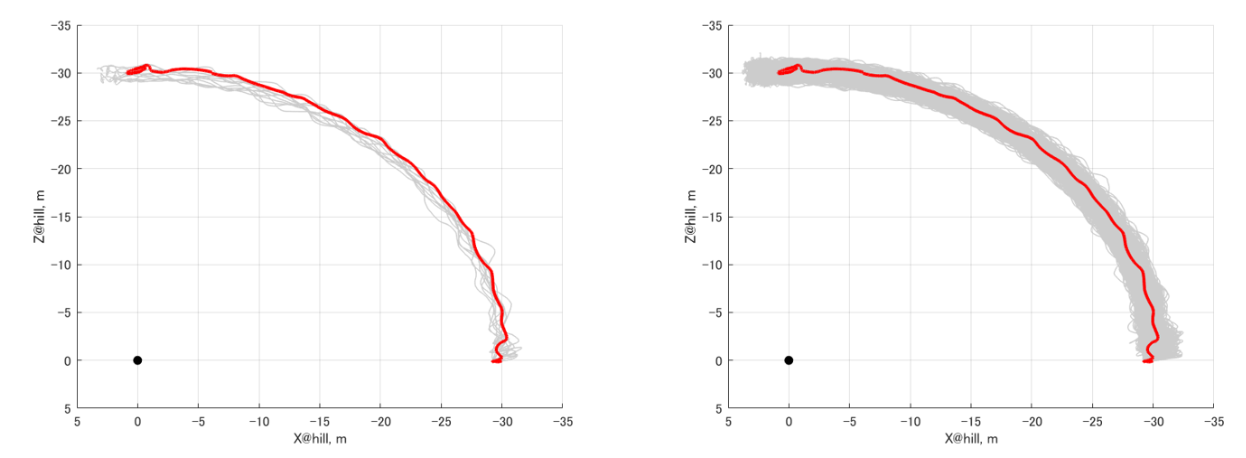

自動ドッキングの軌道上実証は様々なドッキング条件(速度/姿勢など)においても, ドッキング時の発生荷重/モーメント等は規定値以下であることを保証する必要がある. それを確認するために, モンテカルロシミュレーションにて様々な条件(供試体側/環境条件など)を考慮・確認する必要がある. そこで今回, NASAで使用されているドッキングシミュレータであるNASA-TrickをSingularityコンテナにて動作するよう構築し, 実試験前に自動ドッキングのパラメータスタディを実施することができるようになった.

具体的には, NASA-TrickをDockerコンテナ化し, それをJSS3側にてSingularityコンテナへ変換後, バッチジョブにてTrickシミュレーションを並列実行する仕組みを構築できた. これにより最大400並列の計算が実行可能となり, , JSS3 TOKI-RURIにて1. 5ヶ月で数十万ケースのモンテカルロシミュレーションを完遂することが出来た.

成果2.

21年度に開発したJSS3上に準備した多数CPUコアのWindows仮想マシン(Windows-VM)によるSimulinkモデルの並列実行の仕組みを活用し, CRD2プロジェクトにおけるGNCシミュレータの並列実行及びモンテカルロシミュレーションの高速化を実現し, プロジェクトにおけるシミュレーション業務の効率化に貢献した. 具体的には軌道上を模擬したシミュレーション環境上におけるセンサ誤差によるGNC性能評価や制御の安定性を確認する為, センサ誤差を多数振ったモンテカルロシミュレーションをJSS3 Windows-VM上で並列実行した. これにより, 従来は1ケース30分近くかかっていたため, 多数実行のボトルネックになっていたが, 並列実行化により, 32並列での計算が可能となり, 20倍近くの高速化を実現した. これにより5000ケースの計算が2500時間→約5日で実行可能と大幅に効率化を実現できた.

成果3.

22年度に引き続き, Open AIが開発した文字起こしAIであるWhisperと日本の企業であるReazonResearchが開発した文字起こしAIの実力調査を実施した. 文字起こしAIは, ローカル環境で実行するためには大量のGPUメモリを必要とする. 特に最も精度の高いLargeモデルは要求VRAMが10GB以上であり, 普通のPCで動作させることは困難であった. そこで今回, 豊富なVRAMを備えたTOKI-RURI-GPを活用し, Singularityコンテナ化されたWhisper及びReazonResearchのモデルにTOKI-RURIのGPUをアタッチすることにより, OSSの文字起こしAIをJSS3上で動作させる手法を開発した. また, 話者分離が可能なフレームワークであるPyannoteと組合せ, Microsoft Teams等に付属する従来の文字起こしAIではでは実施できなかった1つのマイクでの話者分離を含めた高精度な文字起こしを実現することができた. トライとして研究の年度末評価の音声データを利用し, 話者分離及び各話者の話の内容の記録が可能であることを確認した(精度は概ね65点レベル). 今後は後述の成果3と組合せた文字起こし→要約→議事録化などの自動化がどこまで実現可能であるかの調査を続けていく.

成果4.

成果2で紹介した文字起こしAIに加え, 近年著しい発展をしている大規模言語モデル(LLM)のJSS上でのローカル実行トライを実施した. 具体的にはMeta社が開発し, OSSで公開しているLlama2及びその日本語向け改良版のELYZAのJSS上での実行を試行した. 開発環境の構築も含めてSingularityコンテナを活用し, TOKI-RURI-GPのGPUを使用して動作するGPUコンテナとしてパッケージ化することが出来た.

しかしながら, 最終的に目標としていたAPIによるサービス化についてはWeb APIがまだJSS上では上手く動作できていない為, この点に関しては24年度以降も技術開発及び調査を進めていく予定である.

成果の公表

なし

JSS利用状況

計算情報

- プロセス並列手法: 非該当

- スレッド並列手法: 非該当

- プロセス並列数: 1

- 1ケースあたりの経過時間: 30 分

JSS3利用量

総資源に占める利用割合※1(%): 0.03

内訳

JSS3のシステム構成や主要な仕様は、JSS3のシステム構成をご覧下さい。

| 計算システム名 | CPU利用量(コア・時) | 資源の利用割合※2(%) |

|---|---|---|

| TOKI-SORA | 0.00 | 0.00 |

| TOKI-ST | 224428.43 | 0.24 |

| TOKI-GP | 0.00 | 0.00 |

| TOKI-XM | 0.00 | 0.00 |

| TOKI-LM | 0.00 | 0.00 |

| TOKI-TST | 0.00 | 0.00 |

| TOKI-TGP | 215.77 | 16.61 |

| TOKI-TLM | 0.00 | 0.00 |

| ファイルシステム名 | ストレージ割当量(GiB) | 資源の利用割合※2(%) |

|---|---|---|

| /home | 30.00 | 0.02 |

| /data及び/data2 | 1725.00 | 0.01 |

| /ssd | 0.00 | 0.00 |

| アーカイバシステム名 | 利用量(TiB) | 資源の利用割合※2(%) | J-SPACE | 0.00 | 0.00 |

|---|

※1 総資源に占める利用割合:3つの資源(計算, ファイルシステム, アーカイバ)の利用割合の加重平均.

※2 資源の利用割合:対象資源一年間の総利用量に対する利用割合.

ISV利用量

| 利用量(時) | 資源の利用割合※2(%) | |

|---|---|---|

| ISVソフトウェア(合計) | 0.00 | 0.00 |

※2 資源の利用割合:対象資源一年間の総利用量に対する利用割合.

JAXAスーパーコンピュータシステム利用成果報告(2023年2月~2024年1月)